引言

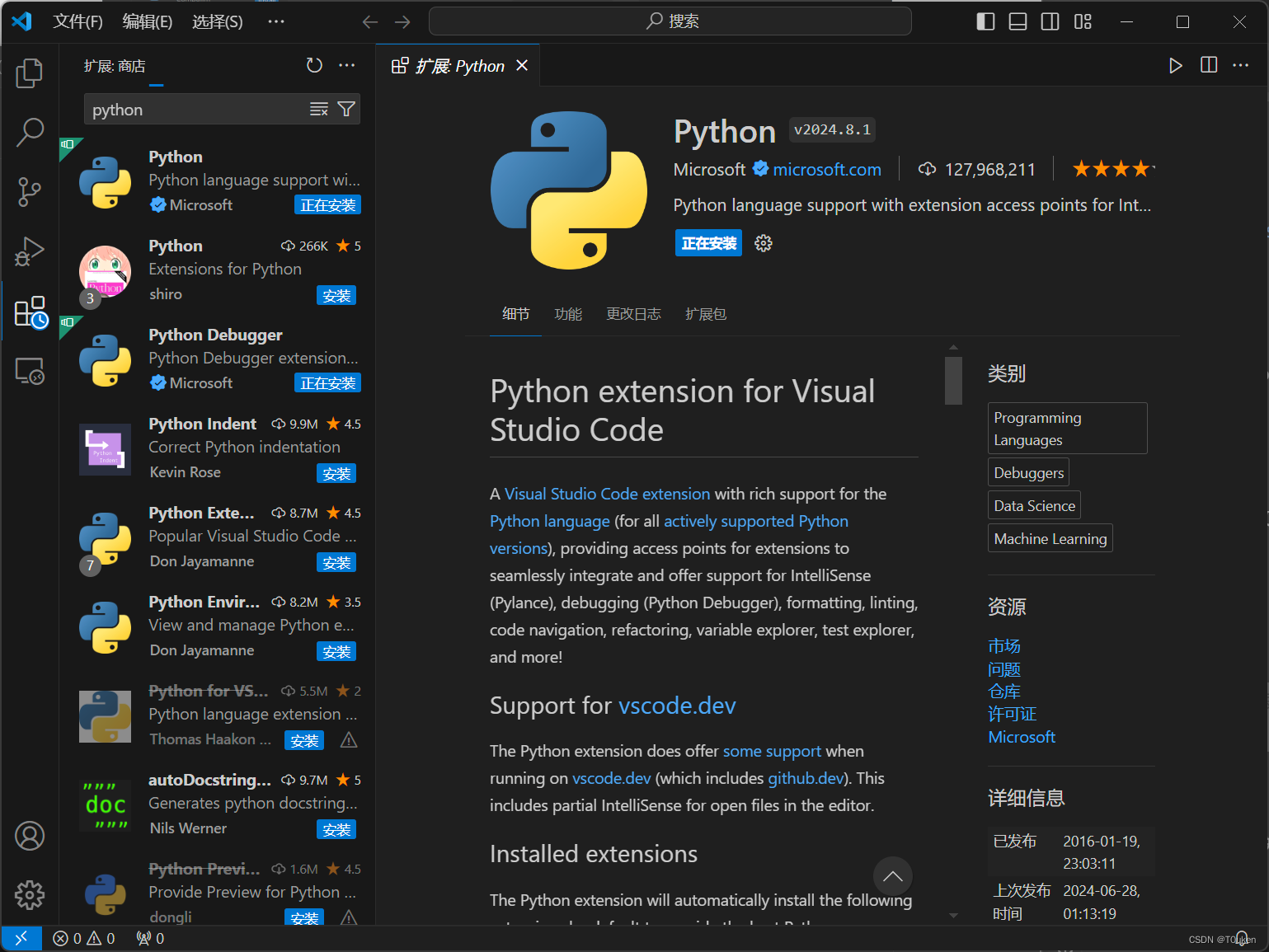

自然语言处理(NLP)是机器学习领域中的一个重要分支,它涉及到让计算机理解和生成人类语言。随着深度学习技术的快速发展,NLP在许多应用领域取得了显著的成果,如机器翻译、情感分析、文本摘要等。本文将深入探讨机器学习实现自然语言处理的背后技术,并通过详细的代码示例来展示其强大的能力。我们将分三大部分来展开,本部分将重点介绍自然语言处理的基本概念和方法。

第一部分:自然语言处理基本概念和方法

1.1 自然语言处理定义

自然语言处理是指通过计算机技术对自然语言文本进行处理和理解,从而实现机器翻译、情感分析、文本摘要等应用。它涉及到语言的理解、生成和评估等方面,是人工智能领域中一个重要的研究方向。

1.2 自然语言处理任务

自然语言处理包括多种任务,常见的任务有:

- 分词:将文本划分为词语序列。

- 词性标注:为文本中的每个词语分配一个词性。

- 命名实体识别:识别文本中的特定实体,如人名、地名等。

- 依存句法分析:分析词语之间的依存关系。

- 情感分析:判断文本表达的情感倾向。

- 文本摘要:从长文本中提取关键信息生成摘要。

- 机器翻译:将一种语言的文本翻译成另一种语言。

1.3 自然语言处理算法

1.3.1 传统机器学习算法

在深度学习流行之前,传统机器学习算法如支持向量机(SVM)、条件随机场(CRF)和朴素贝叶斯(Naive Bayes)等被广泛应用于自然语言处理任务。

from sklearn.feature_extraction.text import CountVectorizer

from sklearn.naive_bayes import MultinomialNB

# 构建词袋模型

vectorizer = CountVectorizer()

X = vectorizer.fit_transform(train_texts)

# 使用朴素贝叶斯进行分类

clf = MultinomialNB()

clf.fit(X, train_labels)

1.3.2 深度学习算法

深度学习算法,特别是循环神经网络(RNNs)和Transformer模型,在自然语言处理任务中取得了显著的成果。这些模型能够自动学习文本的特征,从而避免了手工特征提取的繁琐过程。

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Embedding, LSTM, Dense

# 构建简单的RNN模型

model = Sequential([

Embedding(input_dim=vocab_size, output_dim=64),

LSTM(128),

Dense(1, activation='sigmoid')

])

# 编译模型

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

# 训练模型

model.fit(train sequences, train_labels, epochs=10, batch_size=32)

1.4 数据预处理

在训练自然语言处理模型之前,对数据进行预处理是非常重要的。数据预处理包括分词、去停用词、词干提取等操作。这些操作有助于提高模型的性能和泛化能力。

from nltk.corpus import stopwords

from nltk.stem import PorterStemmer

import re

# 文本预处理函数

def preprocess_text(text):

# 分词

words = re.findall(r'\b\w+\b', text.lower())

# 去停用词

words = [word for word in words if word not in stopwords.words('english')]

# 词干提取

stemmer = PorterStemmer()

words = [stemmer.stem(word) for word in words]

return ' '.join(words)

# 应用数据预处理

preprocessed_texts = [preprocess_text(text) for text in texts]

1.5 模型评估与优化

在训练完模型后,我们需要评估其性能并进行优化。常见的评估指标包括准确率、召回率和F1分数等。此外,我们还可以使用交叉验证、超参数调整等技术来优化模型。

from sklearn.model_selection import cross_val_score

# 评估模型

scores = cross_val_score(clf, X, labels, cv=5)

print("Accuracy: %0.2f (+/- %0.2f)" % (scores.mean(), scores.std() * 2))

结论

本部分介绍了自然语言处理的基本概念和方法,包括传统机器学习算法和深度学习算法。我们还通过代码示例展示了数据预处理、模型评估和优化等步骤。在下一部分中,我们将深入探讨具体的自然语言处理案例,并通过详细的实验来展示模型的性能和泛化能力。

第二部分:自然语言处理案例分析

2.1 数据集介绍

为了更好地理解自然语言处理在实际应用中的工作原理,我们将使用一个流行的数据集——IMDb电影评论情感分析数据集。这个数据集包含了50,000条电影评论,其中25,000条被标记为正面,25,000条被标记为负面。

from tensorflow.keras.datasets import imdb

# 加载IMDb数据集

(train_data, train_labels), (test_data, test_labels) = imdb.load_data(num_words=10000)

2.2 数据预处理

由于IMDb数据集已经进行了预处理,每条评论都被转换为一系列的单词索引,我们可以直接使用这些数据进行模型训练。然而,为了更好地理解预处理过程,我们来看一下如何将单词索引转换回文本。

# 将单词索引转换回文本

word_index = imdb.get_word_index()

reverse_word_index = dict([(value, key) for (key, value) in word_index.items()])

decoded_reviews = [' '.join([reverse_word_index.get(i - 3, '?') for i in train_data[k]]) for k in range(3)]

print(decoded_reviews)

2.3 模型构建与训练

接下来,我们将构建一个简单的循环神经网络(RNN)模型,并使用IMDb数据集进行训练。

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Embedding, SimpleRNN, Dense

# 构建RNN模型

model = Sequential([

Embedding(10000, 32),

SimpleRNN(64),

Dense(1, activation='sigmoid')

])

# 编译模型

model.compile(optimizer='rmsprop', loss='binary_crossentropy', metrics=['accuracy'])

# 训练模型

history = model.fit(train_data, train_labels, epochs=10, batch_size=128, validation_split=0.2)

2.4 模型评估

在模型训练完成后,我们需要评估其性能。我们将使用测试数据集来评估模型的准确率。

# 评估模型

test_loss, test_acc = model.evaluate(test_data, test_labels)

print('Test accuracy:', test_acc)

2.5 模型预测

最后,我们可以使用训练好的模型来预测新的评论的情感。

# 预测单个评论

sample_review = "The movie was great!"

sample_review_index = [word_index.get(word, 0) for word in sample_review.split()]

sample_review_index = pad_sequences([sample_review_index], value=0, maxlen=10000)

prediction = model.predict(sample_review_index)

print("Review sentiment (0=negative, 1=positive):", prediction[0][0])

结论

本部分通过一个实际的案例——IMDb电影评论情感分析,展示了自然语言处理的完整流程,包括数据集介绍、数据预处理、模型构建与训练、模型评估和模型预测。我们使用了一个简单的循环神经网络(RNN)模型,并取得了较高的测试准确率。这个案例展示了机器学习在自然语言处理领域的强大潜力。在下一部分中,我们将进一步探讨如何优化模型结构和参数,以提高模型的性能和泛化能力。

第三部分:模型优化与泛化能力提升

3.1 模型结构改进

在实际应用中,为了提高模型的性能,我们通常需要调整模型的结构。这可能包括增加RNN层的深度、宽度,或者引入更复杂的网络架构,如LSTM和GRU。

# 构建带有LSTM层的RNN模型

model = Sequential([

Embedding(10000, 32),

LSTM(128),

Dense(1, activation='sigmoid')

])

# 编译模型

model.compile(optimizer='rmsprop', loss='binary_crossentropy', metrics=['accuracy'])

# 训练模型

history = model.fit(train_data, train_labels, epochs=10, batch_size=128, validation_split=0.2)

3.2 数据增强

数据增强是一种通过人工方式增加训练数据多样性的技术。它可以提高模型的泛化能力,减少过拟合的风险。在NLP中,数据增强可能包括添加噪声、随机删除或替换词语等。

# 数据增强

from tensorflow.keras.preprocessing.sequence import pad_sequences

# 构建数据增强器

data_augmenter = tf.keras.preprocessing.sequence.TextVectorization(

max_tokens=10000,

output_sequence_length=10000,

output_mode='int',

output_sequence_length=10000,

dtype='int32'

)

# 训练数据增强器

data_augmenter.adapt(train_data)

# 使用增强的数据进行训练

model.fit(data_augmenter.transform(train_data), train_labels, epochs=10, batch_size=128, validation_split=0.2)

3.3 模型评估与超参数调整

为了评估模型的性能,我们需要使用交叉验证和其他技术来调整超参数。此外,我们还可以使用不同的评估指标,如精确度、召回率和F1分数,来全面评估模型。

# 使用交叉验证评估模型

from sklearn.model_selection import StratifiedKFold

kfold = StratifiedKFold(n_splits=5, shuffle=True, random_state=42)

cvscores = []

for train, test in kfold.split(train_data, train_labels):

model = Sequential([

Embedding(10000, 32),

LSTM(128),

Dense(1, activation='sigmoid')

])

model.compile(optimizer='rmsprop', loss='binary_crossentropy', metrics=['accuracy'])

model.fit(train_data[train], train_labels[train], epochs=10, batch_size=128, verbose=0)

scores = model.evaluate(train_data[test], train_labels[test], verbose=0)

cvscores.append(scores[1] * 100)

print("Mean accuracy: %.2f%% (+/- %.2f%%)" % (np.mean(cvscores), np.std(cvscores)))

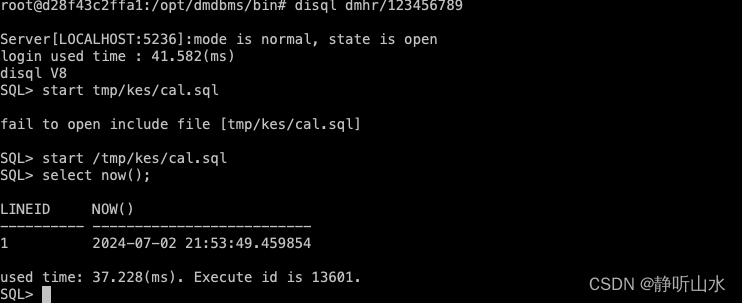

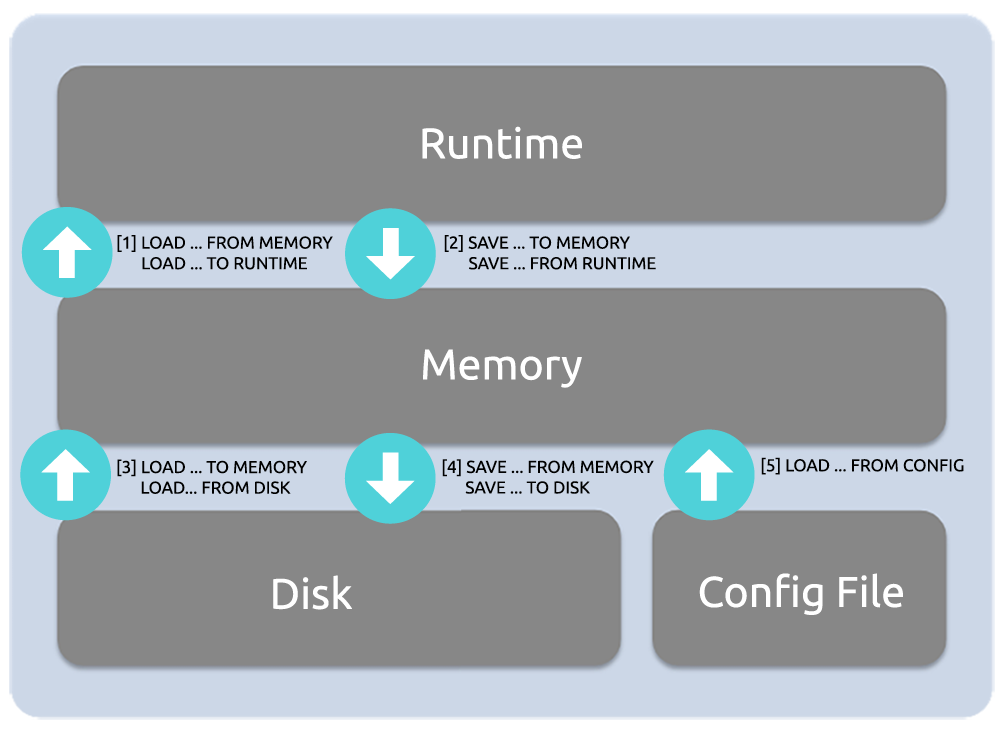

3.4 模型保存与部署

最后,我们需要将训练好的模型保存下来,以便后续的使用或部署。在TensorFlow中,我们可以使用model.save方法来保存模型。

# 保存模型

model.save('imdb_sentiment_model.h5')

3.5 模型部署与API创建

为了将模型投入实际应用,我们可能需要将其部署为一个API服务。这可以通过使用Flask、Django等Web框架来实现。以下是一个使用Flask框架将IMDb电影评论情感分析模型部署为API的示例。

3.5.1 Flask API创建

首先,我们需要安装Flask。如果还没有安装,可以使用pip进行安装:

pip install Flask

然后,我们可以创建一个简单的Flask应用程序来接收文本数据,使用模型进行预测,并返回预测结果。

from flask import Flask, request, jsonify

from tensorflow.keras.models import load_model

import numpy as np

app = Flask(__name__)

# 加载模型

model = load_model('imdb_sentiment_model.h5')

@app.route('/predict', methods=['POST'])

def predict():

# 获取请求数据

data = request.get_json(force=True)

# 解析文本数据

text = data['text']

# 预处理文本

text = text.split()

text = [word_index.get(word, 0) for word in text]

text = pad_sequences([text], value=0, maxlen=10000)

# 使用模型进行预测

prediction = model.predict(text)

predicted_sentiment = 'negative' if prediction[0][0] < 0.5 else 'positive'

# 返回预测结果

return jsonify({'predicted_sentiment': predicted_sentiment})

if __name__ == '__main__':

app.run(debug=True)

在上面的代码中,我们创建了一个POST类型的路由/predict,它接收一个包含文本数据的JSON对象。服务器将解析文本数据,将其预处理为模型可以接受的格式,然后使用模型进行预测,并返回预测结果。

3.5.2 API测试

为了测试API,我们可以使用Python的requests库来发送一个POST请求到我们的API。

import requests

import json

# 构建请求URL

url = 'http://localhost:5000/predict'

# 准备请求数据

sample_text = "The movie was great!"

data = {'text': sample_text}

# 发送POST请求

response = requests.post(url, json=data)

# 打印响应

print(response.json())

3.5.3 生产环境部署

在将API部署到生产环境之前,需要确保它能够在实际的硬件和网络环境中稳定运行。这可能涉及到配置服务器、设置HTTPS、优化性能和安全性等方面。一旦部署完成,API就可以被其他应用程序或服务调用,以实现情感分析的实时预测。

结论

本部分详细介绍了如何优化机器学习模型,包括改进模型结构、使用数据增强、模型评估与超参数调整,以及如何将模型部署为API。通过这些步骤,我们不仅能够提高模型的性能,还能够将其转化为一个实际可用的服务。这些技术和方法对于任何机器学习项目都是至关重要的,它们确保了模型能够在现实世界中得到有效应用。随着技术的不断进步,机器学习在自然语言处理领域的应用将更加广泛,为我们的生活带来更多的便利和创新。

总结

总结而言,本文详细介绍了机器学习在自然语言处理领域的应用,从基本概念和方法出发,逐步深入到案例分析、模型优化和API部署。我们首先探讨了自然语言处理的定义,以及传统的机器学习算法和深度学习算法在此领域的应用。通过IMDb电影评论情感分析数据集的案例,我们展示了数据预处理、模型构建、训练和评估的完整流程。随后,我们讨论了如何通过改进模型结构、使用数据增强、调整超参数等方法来提升模型的性能和泛化能力。最后,我们介绍了如何将训练好的模型部署为API,使其能够被其他应用程序调用,实现实时情感分析。

通过本文的学习,读者应该能够理解机器学习在自然语言处理中的基本原理,掌握模型优化和部署的关键技术,并为将来的实际应用奠定坚实的基础。随着技术的不断进步,机器学习在自然语言处理领域的应用将更加广泛,为我们的生活带来更多的便利和创新。